L'Autorità Garante della Concorrenza e del Mercato, in data 26 luglio, ha autorizzato con condizioni…

Il futuro della memoria digitale. Intervista al Prof. Avv. Roberto Carleo.

Roberto Carleo è Professore ordinario di Diritto privato presso l’Università di Napoli “Parthenope” (Dipartimento di Studi Economici e Giuridici), ove ha insegnato anche Diritto del commercio elettronico.

Insegna Diritto privato (e ora Diritto civile) anche presso l’Università LUISS “Guido Carli”, ove ha insegnato anche European Private Law e Diritto di famiglia (Dipartimento di Giurisprudenza e Dipartimento di Impresa e Management).

In precedenza ha insegnato Diritto privato presso l’Università degli Studi di Teramo (Facoltà di Giurisprudenza), dove è stato per diversi anni Direttore della Scuola di Specializzazione per le Professioni Legali. È autore di svariate pubblicazioni tra cui monografie, saggi, articoli, voci enciclopediche in Riviste scientifiche nazionali ed internazionali. È fondatore e condirettore della Rivista Nuovo Diritto Civile e curatore di un Manuale di diritto privato e di un’edizione del codice civile e leggi complementari.

Il Prof. Avv. Roberto Carleo

Quali sono i vantaggi della conservazione dei dati digitali rispetto a quelli cartacei?

È innegabile che la digitalizzazione dei dati, rispetto al supporto cartaceo, offra vantaggi enormi, anche in termini di conservazione. L’archiviazione elettronica dei dati – tra i molti benefici – consente una consultazione immediata, anche da remoto, e con costi infinitamente minori. Ma soprattutto consente un enorme risparmio di spazio.

Per fare un esempio attuale, in questi giorni circola tra gli avvocati del Foro di Roma una comunicazione del Presidente del Tribunale che impone a chi sia interessato alla conservazione dei fascicoli delle cause esaurite da tre anni di attivarsi subito per chiederne il ritiro presso la cancelleria, perché altrimenti saranno mandati al macero. Se una grossa mole di carte è dispendiosa da conservare, invece oggi intere cancellerie o biblioteche di dati cartacei possono essere conservate digitalmente in piccolissimi supporti di memoria o sul cloud (che è uno dei fenomeni più importanti delle novità della rete, che merita la massima attenzione).

Guardando in particolare ai libri, ci sono ragioni ulteriori che inducono a conservarli nel tradizionale supporto cartaceo, diffidando di affidarsi alla sola conservazione digitale. Un “inno alla carta” è promosso da voci molto autorevoli, tra cui quella dello storico statunitense e direttore della biblioteca dell’Università di Harvard (cfr. Robert Darnton, Il futuro del libro, Adelphi, Milano, 2011).

Tuttavia il problema della conservazione digitale deve essere affrontato tenendo in considerazione tutti i dati che circolano nella rete e non circoscritto soltanto ai libri o alle pubblicazioni. Molti sono gli interrogativi che si pongono: la capacità di conservazione dei dati digitali è “infinita” oppure ha comunque un limite? La conservazione di un dato digitale quanto dura? Il dato digitale davvero non è modificabile e non deteriorabile?

È significativo notare come non manchino anche esperti di informatica i quali suggeriscono come soluzione per la massima sicurezza possibile della conservazione dei dati più importanti quella di adottare la cautela di stamparli su carta.

Sul punto sono davvero suggestive (ed inquietanti) le parole di Vinton Cerf, padre fondatore di internet e poi vicepresidente di Google (dove ha assunto la carica di “Chief Internet Evangelist“, ovvero, letteralmente, Evangelista-Capo di Internet): “Pensando a 1000, 3000 anni nel futuro, dobbiamo domandarci: come preserviamo tutti i bit di cui avremo bisogno per interpretare correttamente gli oggetti che abbiamo creato? Senza neanche rendercene conto, stiamo gettando tutti i nostri dati in quello che rischia di diventare un buco nero dell’informazione”; il problema dunque è che il bit, pur se fosse eterno, deve essere decifrato da tecnologie che mutano e si evolvono, fino a diventare obsolete ed inutilizzabili, tanto che: “Nei secoli a venire chi si farà delle domande su di noi incontrerà delle enormi difficoltà, dal momento in cui la maggior parte di ciò che ci lasceremo dietro potrebbe essere solo bit non interpretabili”. Di talché: “Il mio consiglio è: se ci sono foto a cui davvero tenete, createne delle copie fisiche. Stampatele” (cfr. Giulia Belardelli L’Huffington Post, Google, Vint Cerf lancia l’allarme: “Dietro di noi un deserto digitale, un altro Medioevo. Se tenete a una foto, stampatela“).

Concentriamoci sui problemi della conservazione dei dati digitali: quali sono i limiti di protezione, durata, caducità e quantità? Chi decide quali dati conservare?

Partirei innanzitutto dalla quantità sempre maggiore di dati che circolano nella rete. Dati impressionanti sono raccolti in un interessante servizio della trasmissione Report. La crescita esponenziale del numero è talmente rilevante che occorrono capacità di calcolo particolare già solo per comprendere la dimensione delle unità di misura multiple dei byte che ormai sono arrivate a: Petabyte, Esabyte e Zettabyte.

Ci sono 1 milione di miliardi di byte creati (5mila petabyte al giorno; 44 Zettabyte l’anno) creati dal traffico di circa 4 miliardi di utenti della rete. Il punto è che creiamo dati più velocemente della capacità di conservarli (tutti).

Il cloud (che merita un approfondimento a parte) aumenta lo spazio e contribuisce a risolvere i problemi di aggiornamento del software, ma riduce la autonomia di gestione della conservazione, con le relative conseguenze in termini di scelta dei dati da conservare, di modalità di accesso e di durata della conservazione. Comunque anche il cloud (almeno fino ad oggi) da qualche parte “atterra” e i dati della nuvola vengono comunque conservati in “data set” (casseforti di dati) localizzati in supporti terrestri (sebbene una delle prossime frontiere di internet sembra quella di concepire dei nuovi protocolli per consentire un efficiente funzionamento della rete anche oltre il nostro pianeta: cfr. Vint Cerf e il futuro di Internet: tre predizioni).

La “localizzazione” del server diventa discriminante per sciogliere i problemi giuridici della individuazione della legge applicabile, ovvero segna il territorio sottoposto alla sovranità di leggi capaci di regolare il cloud o, in generale, lo spazio “a-territoriale” della rete (sui limiti territoriali della legge, si rimanda al libro di Natalino Irti, Norma e luoghi. Problemi di Geo-diritto, Bari, 2001).

Allora il problema più importante diventa quello di stabilire le regole sulla scelta dei dati da conservare (oltre che sulle modalità della conservazione). Quali sono i criteri di selezione dei dati da conservare da quelli che non si intende conservare per “liberare spazio”? Chi decide? Gli stati troveranno soluzioni condivise?

La conservazione non può essere lasciata solo alle finalità commerciali. La legge deve prevalere sul mercato: se il legislatore non interviene, allora anche questa sarà una scelta politica (ancora una volta, anche sul primato della legge sul mercato, non ci si può esimere dal richiamare Natalino Irti, L’ordine giuridico del mercato, Bari, 1998).

Si pone, in altri termini, un problema di “democrazia digitale”, per evitare di cadere in una “dittatura digitale”. Lo spazio non basta più per tutta la mole crescente di dati, di talché bisogna scegliere quali conservare e quali abbandonare. Allo stato appare giocoforza che qualcosa dovrà essere “dimenticato”.

Molti archivi digitali stanno affrontando il problema della carenza di spazio necessario per la conservazione dei dati: si pensi, ad esempio, all’Internet Archive di San Francisco il quale è una biblioteca digitale non profit che ha lo scopo dichiarato di consentire un “accesso universale alla conoscenza” e che utilizza l’interfaccia “Wayback Machine” che permette di accedere a versioni archiviate di pagine web del passato, come una sorta di “archivio tridimensionale“, ovvero un gigantesco database che contiene l’archivio di milioni di siti web con i rispettivi dati – che vuole restringere la conservazione solo ai libri; oppure si pensi alla Library of Congress, ovvero la biblioteca del Congresso di Washington, che ha scelto di limitare taluni dati da conservare (ad esempio i tweet o i messaggi pubblici) solo a quelli relativi alle elezioni o ad altri profili reputati importanti.

Torna il monito di Vinton Cert sulla eventualità di una “generazione dimenticata”, se i dati non saranno più leggibili in futuro: pur conservando i supporti hardware, potrebbero diventare inutilizzabili in particolare i software per leggerli.

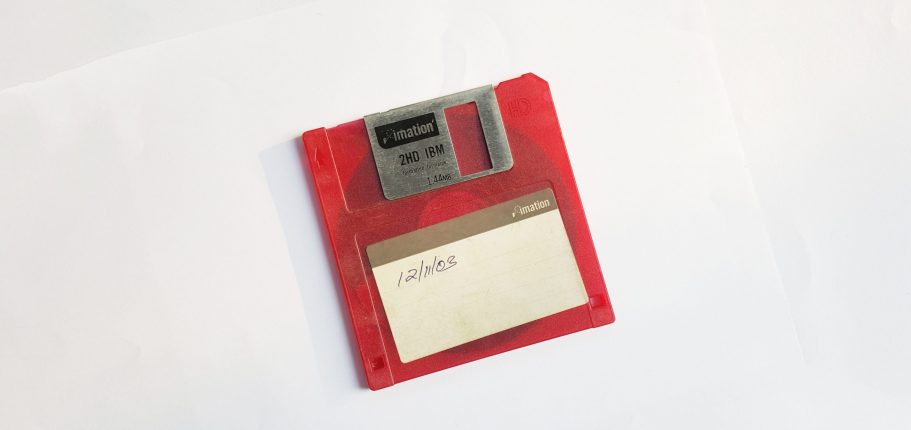

Oltre al problema della scelta dei dati da conservare, si pongono quindi i problemi di garantire e proteggere la conservazione stessa nel tempo. Il dato può deteriorarsi e non essere più decodificabile. Si pensi, dopo appena 20 anni, alla difficoltà oggi di leggere un vecchio floppy disk. Ne consegue che è necessario un continuo “aggiornamento” del supporto mediante una costante “migrazione” dei dati. Dunque la conservazione elettronica sembrerebbe potersi realizzare attraverso un “fluire dinamico” tramite un “servizio” di aggiornamento costante (in quanto tale mutevole), e non mediante un “bene” (materiale o immateriale) che assicuri una “conservazione statica” (e in quanto tale immutabile), così come è stato per il supporto cartaceo, che si deteriora, ma non muta il proprio criterio di decifrazione.

Infine va tenuto in considerazione che il problema della archiviazione si pone non solo per i dati che si vogliono conservare nel tempo (selezionandoli) ma anche per la rintracciabilità, “a breve termine”, di quelli che vengono prodotti quotidianamente (dunque indiscriminatamente conservati, senza distinzioni), come ad esempio talune registrazioni video di telecamere di sicurezza.

Quanto tempo devono rimanere disponibili? Come selezionare quelli che potrebbero essere meritevoli di conservazione a lungo termine?

Torniamo ancora sul cloud, alla cui rilevanza già si è accennato: quali sono i vantaggi per la conservazione dei dati?

Sul cloud un altro ordine di vantaggi – oltre a quelli ai quali abbiamo già accennato – si sostanzia in quelli organizzativi, che consistono nella sistematizzazione delle infrastrutture, nella riorganizzazione dei flussi informativi e, di conseguenza, nel miglioramento della fruibilità dei dati all’interno del sistema.

Vi sono inoltre evidenti vantaggi anche di carattere gestionale: difatti le infrastrutture condivise sulle quali vengono ospitati i servizi cloud vengono progettate per garantire un’erogazione costante di potenza elaborativa all’aumento te delle istanze applicative a del numero di utenti attivi. Peraltro il cloud consente anche di ipotizzare il superamento totale del concetto di aggiornamento del software in uso, in quanto le applicazioni in cloud vengono costantemente aggiornate dal fornitore del servizio sull’infrastruttura condivisa.

Tutto ciò porta anche un evidente risparmio in termini organizzativi, di sicurezza e di costi per la gestione e l’amministrazione, poiché tali spese di mantenimento e aggiornamento sono a carico del cloud service provider. D’altro canto, si pongono i problemi connessi alla esternalizzazione del servizio di conservazione dei dati, che viene gestito nel tempo da un terzo professionista specializzato, al quale l’utente si trova a doversi affidare senza poter soddisfare autonomamente e in modo statico e definitivo la propria esigenza.

Il passaggio – al quale già abbiamo accennato – dalla titolarità di un diritto di proprietà su un bene fisico, che funga da supporto di memoria, ad un servizio di gestione della conservazione, prestato da un professionista specializzato, rientra nel contesto attuale della economia dei servizi che caratterizza questa epoca, notoriamente definita “era dell’accesso” (il riferimento è a Jeremy Rifkin, L’era dell’accesso. La rivoluzione della new economy, (2000) traduzione di Paolo Canton, Mondadori, Milano, 2001), in cui l’acquisto della proprietà dei beni (atto istantaneo) è sostituito da contratti di accesso a servizi che consentono il godimento (rapporto di durata).

Ne derivano, quindi, oltre ai problemi del trattamento dei dati da parte del terzo (materia ampiamente dibattuta e regolata dal GDPR, General Data Protection Regulation), i rischi di incorrere nelle patologie del rapporto contrattuale di somministrazione del servizio e in altre vicende che possono occorrere al terzo fornitore, che potrebbero in qualche modo riverberarsi anche sulla prestazione di conservazione dei dati, influendo anche sulla sua certezza e stabilità.

Quali sono i possibili obiettivi di miglioramento dell’efficienza dei supporti di conservazione dei dati digitali, anche in termini di risparmio energetico e di tutela dell’ambiente?

Attualmente si ricerca un sistema per ridurre la dimensione fisica dei supporti di conservazione dei dati, per aumentarne la capacità. Nonostante gli enormi progressi degli ultimi decenni sulla capacità delle memorie informatiche, si attende ora un’ulteriore svolta. L’istituto Charles Sadron di Strasburgo sta studiando come nuova soluzione una molecola o meglio un polimero sintetico (tipo codice DNA) costituito da una sorta di “provetta”. La scala molecolare, rispetto agli attuali supporti di archiviazione di memoria, dovrebbe consentire di ridurre dalle 10 alle 100 volte la dimensione fisica dei supporti di memoria, con conseguente aumento della capacità di immagazzinare dati.

Anche in tema di conservazione dei dati si pongono rilevanti problemi energetici e dunque di impatto ambientale. L’attenzione a questi temi si è accresciuta negli ultimi tempi guardando al consumo energetico dei Bitcoin, che rappresenta un costo da considerare per la diffusione della moneta elettronica.

Per avere un’idea di massima, mutuando ancora i dati del servizio di Report già sopra richiamato, la comunicazione elettronica di 1 gigabyte consuma circa 200 litri d’acqua (per cui la semplice visione di un film in streaming consuma l’equivalente di oltre 600 litri). L’acqua, dunque, costituisce una misura di energia “pulita”, propria della green economy. I consumi di energia per il traffico dei dati non sono generati solo dal funzionamento ma in gran parte anche per il raffreddamento delle macchine.

In Europa (si pensi in Italia ad Aruba) e Stati Uniti (ad esempio la Apple) si usano energie rinnovabili (specie idroelettrico e fotovoltaico) ma in altri continenti, come in Asia o in Cina (si pensi ad esempio ad Alibaba) si userebbero ancora oggi centrali a carbone. Anche sotto questo profilo, va da sé che occorrerebbero regole universali da applicare ugualmente in tutti i territori del mondo. Torniamo ancora al problema del limite territoriale della legge, e della conseguente difficoltà di dettare regole uniformi applicabili in tutto lo spazio della rete.

Quale tutela può garantire la “democrazia digitale”? Come può il diritto superare i confini territoriali ed assicurare una protezione globale nello spazio di internet? Può esportarsi il sistema escogitato dal GDPR di designare un “regolatore responsabile”, invece che dettare regole dettagliate (come descritto nel Suo recente articolo: Il principio di accountability nel GDPR: dalla regola alla auto-regolazione, in Nuovo diritto civile, 2021, pp. 359-376)?

Queste sono domande molto difficili.

Come abbiamo detto prima, occorrerebbe una scelta politica diretta a selezionare quali siano i dati da conservare, per non lasciare la scelta alla tirannia del mercato. L’auspicio dovrebbe essere innanzitutto quello che tutti i legislatori riescano a dettare insieme delle regole comuni per garantire la conservazione dei dati ed evitare il rischio di “generazioni dimenticate”, oppure di scelte imposte dai competitori più forti del mercato esclusivamente nel proprio interesse. Ma, posta la atavica difficoltà di applicazione di una regola concordata da tutti gli stati sovrani, occorre forse auspicare che gli stessi operatori della rete sappiano autoregolamentarsi adottando scelte responsabili e adeguate.

L’ultima domanda contiene forse una possibile risposta, suggerendo l’ipotesi di estendere la soluzione adottata dal Regolamento Europeo per la Protezione dei Dati per risolvere il problema della applicazione del regolamento anche fuori dai confini territoriali della Unione Europea. La tecnica legislativa sperimentata dal GDPR è quella di abbandonare la regola di dettaglio, e responsabilizzare un soggetto deputato a scegliere le regole più adeguate alla tutela del trattamento dei dati, ovunque essi vengano a trovarsi.

Questo “regolatore responsabilizzato”, che nel GDPR è il data controller, è libero di scegliere le soluzioni più adeguate per il raggiungimento dell’obiettivo (che resta fissato dal legislatore), della cui idoneità il data controller poi verrà chiamato a rispondere ove insorgano problemi. È l’applicazione del c.d. principio di accountability (parola di difficile traduzione in lingua italiana giacché contiene in sé contestualmente vari significati, quali quelli di libertà, responsabilità, prova e rendicontazione).

In questa maniera la regola riesce a funzionare anche in uno spazio a-territoriale, qual è appunto quello di internet, che tende a sfuggire alla sovranità del diritto statale che opera solo sul territorio di riferimento e richiede quindi nuovi criteri di protezione che consentano lo “scollamento tra legge e territorialità” (Si esprime così Luciano FlorIdi, Il verde e il blu. Idee ingenue per migliorare la politica, Milano, 2020, p. 28 s., il quale elogia appunto questo metodo adottato dal GDPR “che, in modo geniale, supera lo scollamento post-vestfaliano, sfruttando invece la saldatura … tra identità personale e dati, per giustificare il fatto che, ovunque i dati di un cittadino europeo siano processati, si applica comunque la legge europea”. Poi l’A. prosegue: “Il GDPR lega i dati alla fonte e non la legge al territorio, un po’ come la logica del passaporto, che non dà diritto ad espatriare (per esempio a volte serve anche un visto) ma a rimpatriare, legando il portatore alla sua nazionalità, come un elastico”).

Tuttavia la principale difficoltà di esportare questa soluzione dettata per il trattamento dei dati anche alla conservazione degli stessi risiederebbe proprio nel fattore temporale, che incide sulla stabilità. Infatti, mentre in caso di trattamento dei dati la scelta delle modalità più adeguate si risolve rapidamente e quindi può funzionare bene la soluzione di designare un soggetto che scelga la regola più adeguata restando responsabile di eventuali patologie, viceversa per la conservazione, che è destinata a durare nel tempo, la designazione di un soggetto responsabile che sia chiamato ad un rendiconto molto tempo dopo appare meno efficace, proprio per la difficoltà di mantenere stabilmente il soggetto che detta la regola e ne garantisce la adeguatezza. Ad ogni buon conto, la storia ci dirà come verrà regolata la conservazione dei dati.

Verosimilmente, anche a prescindere dagli interventi legislativi, le grandi imprese che governano la rete sapranno autodisciplinarsi (ovviamente anche nel proprio stesso interesse e nel perseguimento della propria mission) per adottare le soluzioni più efficienti al fine di garantire la conservazione dei dati, garantendo così il servizio offerto. Ma forse le soluzioni potrebbero arrivare – in un futuro non lontano – proprio dal progresso tecnologico e dalle intelligenze artificiali.

Oggi l’attenzione comincia a incentrarsi sul “computer neuromorfico” che sembrerebbe rappresentare il futuro (anche) del cloud. Gli sviluppi della innovazione tecnologica, della digitalizzazione, della intelligenza artificiale e in particolare anche l’ultima frontiera del computer neuromorfico – che animeranno sempre di più nel prossimo futuro i dibattiti legislativi e giurisprudenziali in tutto il mondo – stanno già catalizzando gli interessi, tra gli altri, ad esempio, dei mercati finanziari (con la creazione e la crescita di fondi di investimento tematici) e anche delle organizzazioni internazionali (tra cui la NATO, per le strategie di preparazione alla cyber war ). L’intelligenza artificiale non è più basata solo sulla potenza di calcolo delle macchine bensì anche sulla creazione di nuove macchine che siano in grado di processare enormi quantità di dati con la finalità di imparare, adattarsi ed evolversi, proprio come il cervello umano. La nuova frontiera del “calcolo neuromorfico” dovrebbe consentire alle macchine di apprendere e di pensare. E chissà, allora, se proprio le macchine non potranno esse stesse diventare capaci di scegliere e selezionare i dati che devono essere adeguatamente conservati nel tempo e ricordati nella memoria digitale.

Approfondimenti:

- Rivista Nuovo Diritto Civile

- “Il principio di accountability nel GDPR: dalla regola alla auto-regolazione, in Nuovo diritto civile”, 2021, Roberto Carleo

- “Dietro di noi un deserto digitale, un altro Medioevo. Se tenete a una foto, stampatela“

- Trasmissione Report – Memoria a breve termine

- Vint Cerf e il futuro di Internet: tre predizioni

- Internet Archive di San Francisco

- Biblioteca del Congresso di Washington

- L’istituto Charles Sadron di Strasburgo

- Fondi di investimento tematici

- Cyber war