L'Autorità Garante della Concorrenza e del Mercato, in data 26 luglio, ha autorizzato con condizioni…

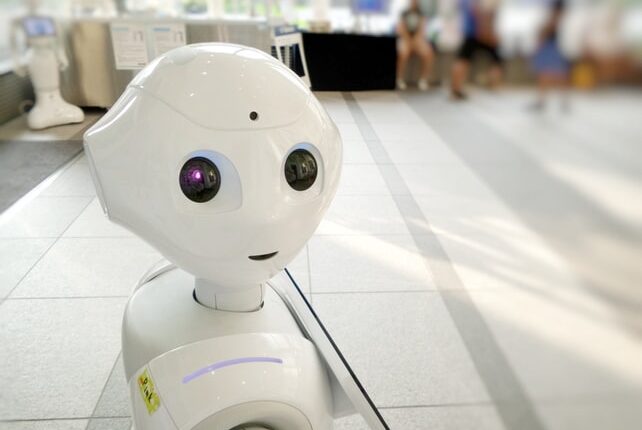

Il Libro Bianco curato dalla Task Force IA del MISE, la Strategia Nazionale per l’intelligenza artificiale. Intervista al Prof. Avv. Eugenio Prosperetti.

In occasione del Libro Bianco appena pubblicato dalla Task Force del MISE, la redazione di DIMT ha intervistato il Prof. Avv. Eugenio Properetti: avvocato specializzato in information technology, privacy, media e Docente Giurisprudenza LUISS Legal Aspects of Information Technology; titolare dello Studio legale Prosperetti.

Il Prof. Avv. Prosperetti ha fatto parte della Task Force IA dell’Agid specifica all’uso dell’IA nella Pubblica Amministrazione.

Il Libro bianco è stato curato dalla Task Force IA del MISE. Sono stati coinvolti circa un centinaio di soggetti pubblici e privati che a vario titolo si occupano di IA in Italia. Il documento riguarda il Sistema Paese nel suo complesso e, dunque, anche le amministrazioni pubbliche prevedendo raccomandazioni e indicazioni in merito alle opportunità aperte dall’Intelligenza Artificiale. In che modo viene trattato il tema della responsabilità della pubblica amministrazione e dei privati in materia di l’Intelligenza Artificiale? Secondo Lei, la Strategia tocca aspetti più universali del mondo IA in una visione efficace della materia?

A mio avviso il pregio del documento pubblicato dalla Task Force e che mi ha positivamente colpito è la sua visione generale. Prevedere una strategia per l’IA vuol dire adeguare il sistema e l’ordinamento all’avvento di questa tecnologia, più che disciplinare la tecnologia in sé. E’ certamente complesso compendiare un documento di circa 150 pagine in poche battute ma meritano di essere citati (non in ordine) alcuni passaggi significativi.

Anzitutto il fatto che la Task Force si sia preoccupata di porre un deciso accento sul fatto che incentivare e diffondere l’utilizzo di tecnologie di IA è certamente una scelta che porta l’Italia nella modernità ma che non può essere compiuta senza adeguamenti del sistema normativo. Tali adeguamenti non si limitato all’approvazione di una o due leggi speciali ma riguardano il modo in cui si fanno leggi e regolamentazioni in Italia. Occorre potenziare decisamente gli strumenti di c.d. “better regulation” con una valutazione indipendente e puntuale a supporto dell’operato del Legislatore, che valuti con attenzione le conseguenze delle norme che vengono approvate e tenga coordinato il sistema.

Altro elemento importante riguarda l’impatto dell’uso di tecnologie AI sugli istituti della responsabilità civile ed amministrativa. L’intelligenza artificiale non è certo una “intelligenza” alternativa (il termine intelligenza è fuorviante), si tratta di sistemi in grado di apprendere ed emulare acriticamente processi di ragionamento umano tramite tecniche di addestramento ed apprendimento. Una IA può apprendere cose intelligenti e cose stupide, cose giuste e cose sbagliate e riprodurle tutte, senza distinguere e senza capire. Tuttavia, riprodurre il ragionamento vuol dire che, in linea teorica, il risultato del processo può essere una scelta e tale scelta potrebbe essere giusta o sbagliata. Proprio per questo affidare una decisione del settore pubblico o privato a un sistema AI pone il problema di chi sia “responsabile” della scelta compiuta dal sistema. Se, banalmente, si affida la correzione del compito di un concorso pubblico ad una IA e l’IA esclude erroneamente un candidato, chi sarà il responsabile dell’errore? Se l’IA accoglie una richiesta di pensione senza che vi siano i requisiti, chi sarà il responsabile dei pagamenti illegittimi? Se, nel privato, un sistema di IA nega un finanziamento o un mutuo prima casa a richiedenti meritevoli, chi sarà il responsabile?

La Task Force fa varie considerazioni interessanti sul fatto che la macchina, di per sé, non porta responsabilità e vi sono già nell’ordinamento vari sistemi per estendere le responsabilità delle persone ai sistemi da essi utilizzati per adempiere ai propri compiti. Interessante il riferimento all’art. 2052 del Codice Civile sulla responsabilità per cose in custodia. Il tema andrà comunque attentamente presidiato. E’ inoltre presente il riferimento ai principi elaborati dal Gruppo ad Alto Livello UE che prevedono una visione antropocentrica dell’AI, tra i quali spicca quello che prevede sempre che il danno cagionato all’individuo dall’AI debba poter trovare ristoro e che l’uso dell’AI debba essere rispettoso dell’integrita’ personale e trasparente.

Vorrei infine citare, se pensiamo al tema della responsabilità amministrativa (su cui già in Italia si esercitò la Task Force AI di Agid di cui facevo parte) il tema dell’obbligo di motivazione che caratterizza il nostro diritto amministrativo: i sistemi di IA, di per sé, non sono in grado di motivare le proprie scelte a meno che non vengano progettati per farlo. Dunque, per una pubblica amministrazione, utilizzare sistemi che decidono in maniera tassativa, senza che sia possibile capire il processo decisionale, agendo in base a programmazioni black box, potrebbe essere problematico in quanto ogni decisione sarebbe suscettibile di essere annullato a livello giurisdizionale.

Nella Strategia vengono toccati temi importanti riguardanti il trattamento dei dati pubblici e privati in ambito di IA. Nello specifico, si parla di modalità di gestione di questi dati. Secondo Lei come può essere esaminato il diritto della gestione dei dati in ambito della Strategia Nazionale in IA italiana ed in merito a tutte le banche dati mondiali? Quali sono, a Suo parere, le principali problematiche e criticità?

Il tema della gestione dei dati assume con l’intelligenza artificiale una strategicità e centralità a livello mondiale oltre che nazionale.

Non si parla qui solo di dati personali, da tempo al centro della scena per via del noto Regolamento GDPR. Parliamo di varie tipologie di dati, presenti nelle banche dati pubbliche e private, quali i dati delle imprese, i dati economici, i dati sanitari, i pubblici registri, le banche dati geografiche, ecc.

Da tempo la dottrina e le stesse istituzioni comunitarie si interrogano sull’adeguatezza dell’attuale normativa a tutela delle banche dati alle sfide future e questa è una componente del tema che Lei mi chiede di commentare, ma non è la sola.

Come correttamente indica la Task Force, l’uso dei dati per creare e, soprattutto, per utilizzare sistemi di IA non è materia che si può interamente risolvere con le regole esistenti, italiane od europee che siano.

Infatti, i sistemi di intelligenza artificiale per funzionare, per “imparare” non possono essere alimentati con qualsiasi tipo di dato, proveniente da qualsiasi fonte.

Occorre che i dati siano “pensati” ad hoc, come categorie e tipologia per essere idonei all’apprendimento da parte di un sistema IA ma, ancor più, occorre che i dati siano annotati, accompagnati

cioe’ da specifici dati a supporto che contestualizzano come e’ stato raccolto il dato per evitare che l’intelligente “intelligenza” ne equivochi la natura. Per fare un esempio, un indirizzo geografico può essere una partenza o una destinazione o una tappa intermedia o dove si trova un individuo o una struttura o, ancora, un dato anagrafico. Senza l’annotazione il sistema non lo riesce a capire e non è in grado di capirne l’importanza.

Questo problema tecnico ha importanti riflessi normativi perche’ non è previsto che i dati siano raccolti, nel pubblico e nel privato, come “annotati”. La Task Force ipotizza strumenti regolamentari per regolare l’accessibilità dei dati come essential facilities (anche nel privato) per fare in modo che le grandi basi dati utili allo sviluppo di sistemi di IA di interesse pubblico diventino un bene comune.

Questo ragionamento avrà una importanza crescente nel dibattito futuro ed è un altro dei temi che sottolineano come l’avvento delle tecnologie di AI impone un ripensamento molto ampio di consolidati modelli regolamentari ed organizzativi.